-

Word EmbeddingsGoogle ML Bootcamp/Sequence Models 2023. 10. 1. 12:14728x90

※ Using Word Embeddings

- 낮은 차원의 feature vector를 사용할 수 있다. -> 1만 차원 one-hot vector를 사용하는 대신 300차원의 dense vector를 사용할 수 있다.

- finetuning의 경우 차원이 매우 크고, 데이터가 많을 경우에만 사용한다.

- 상대적으로 작은 훈련 세트를 가질 때 가장 큰 차이를 만드는 경향이 있다.

- 명명된 Entity 인식, 텍스트 요약, 공동 참조 해결, 구문 분석에 유용하고, 언어 모델링, 기계 번역에 적합하지 않다.

- A에 대한 데이터 양이 많은 경우에 가장 유용하고, B에 대해 상대적으로 작은 데이터 셋을 가질 때 유용하다.

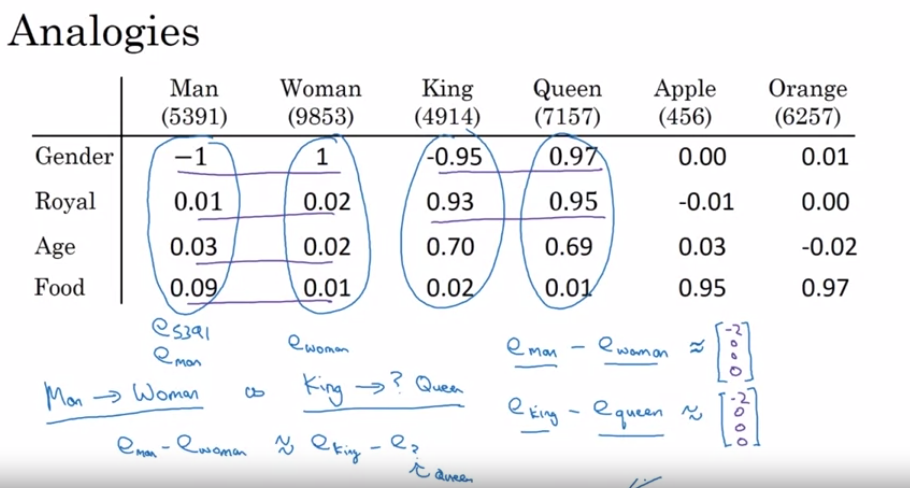

※ Properties of Word Embeddings

- e(man) - e(women) = [-2 0 0 0]

- e(king) - e(queen) = [-2 0 0 0]

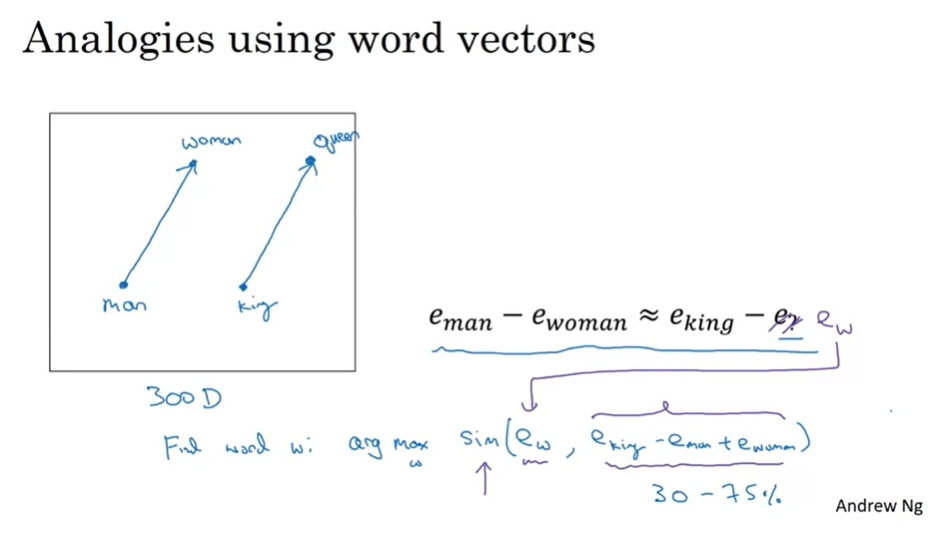

- man과 women는 king과 무엇과 같은가? -> A. e(man) - e(women)을 통해서 벡터를 찾아내고, 단어를 찾아낸다. 결국 e(king) - e(queen)과 거의 유사한 결과를 보이므로, 답을 queen이라고 할 수 있다.

- 이와 같은 계산을 통해 argmax를 사용하고 유추를 할 수 있다.

- sim(e_w, e_king - e_man + e_woman) : 코사인 유사성

■ t-SNE Algorithm

- 하지만 이와 같은 t-SNE 알고리즘은 비선형적이기 때문에 평행사변형 유추관계가 깨지게 된다.

※ Embedding Matrix

728x90

728x90'Google ML Bootcamp > Sequence Models' 카테고리의 다른 글

Transformer Networks (1) 2023.10.04 Various Sequence To Sequence Architectures (0) 2023.10.03 Learning Word Embeddings: Word2vec & GloVe (0) 2023.10.02 Recurrent Neural Networks (0) 2023.09.29