-

Deep Neural NetworkGoogle ML Bootcamp/Neural Networks and DL 2023. 9. 10. 14:26728x90

1. Deep L-Layer Neural Network

- 숨겨진 층의 수를 다양한 값을 시도할 수 있는 하이퍼파라미터로 표시하고 유효성 검증 데이터 또는 개발 세트에서 평가하는 것이 합리적이다.

- 4 Layer N(3 hidden Layer)

2. Forward Propagation in a Deep Network

- 명시적인 for loop를 사용하는 것이 좋다.

3. Getting your Matrix Dimensions Right

- Vectorization 한 상태와 아닌 일반적인 상태 각각의 차원을 위와 같이 표현할 수 있다.

4. Why Deep Representations?

- 복잡한 부분을 탐지하기 위해 단순한 가장자리들을 탐지하는 것이 중요하다. 깊이를 늘리면서 점점 복잡한 것들까지 탐지한다.(Simple -> Complex)

- 음성 : 낮은 레벨의 오디오 웨이브 형식을 감지(백색소음에 가까움) -> 음소를 인식(소리의 기본 단위를 찾음) -> 오디오에서 단어를 인식하고 더 복잡한 문장을 인식.

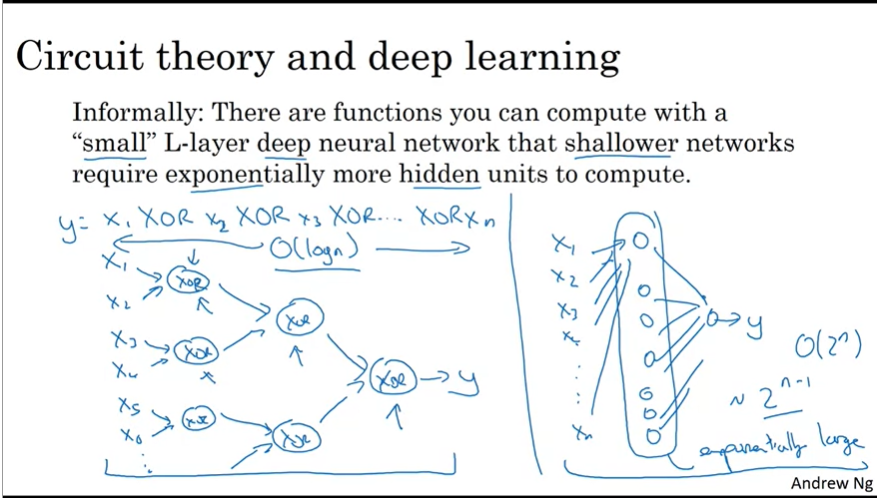

- 얕은 신경망보다 깊은 신경망이 훨씬 낮은 시간복잡도를 불러올 수 있다.

5. Building Blocks of Deep Neural Networks

- 심층 신경망을 구성하고 있는 기본 층 구조에서의 값들을 위와 같이 나타낼 수 있으며

점화식으로 w[l] = w[l] - learning_rate * dw[l], b[l] = b[l] - learning_rate * db[l] 로 최종적으로 표현이 가능하다.

6. Forward and Backward Propagation

7. Parameters vs Hyperparameters

- 분야마다 가장 최적의 값이 변할 수 있다. 매일 최적값으로 하이퍼파라미터를 튜닝한다고 하더라도 가장 최적의 값이 1년 후에는 또 CPU나 GPU의 발전으로 변할 수 있다.

- 몇 개의 파라미터를 사용해서 체크를 한 후 더 좋은 하이퍼 파라미터가 있는지도 끊임없이 확인을 해야한다.

- cross-validation과 같은 평가를 통해서 문제에 가장 잘 맞는 값을 선택하는 것이 바람직하다.

728x90'Google ML Bootcamp > Neural Networks and DL' 카테고리의 다른 글

Shallow Neural Network (0) 2023.09.06 Logistic Regression as Neural Network (0) 2023.09.03